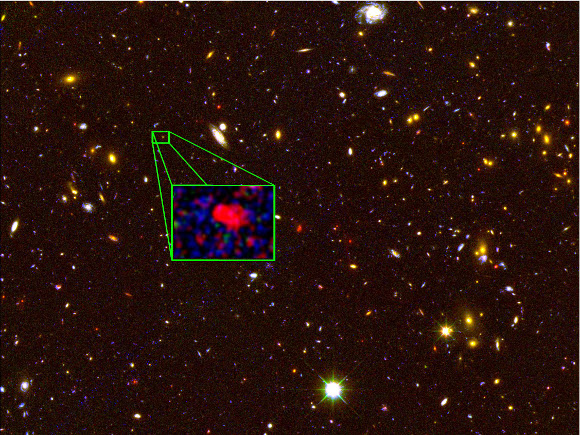

Voilà un résultat négatif qui est peut-être aussi important que s'il avait été positif (enfin... non, quand même pas finalement). La collaboration LUX vient de rendre public ses premiers résultats obtenus grâce au détecteur de matière noire le plus performant du moment, lors d'un séminaire présenté par Dan McKinsey et Rick Gaitskell.

Ils atteignent une sensibilité de détection hors norme, permettant d'explorer une zone jusqu'alors jamais atteinte (une section efficace qui descend jusque 10-45 cm² et une masse détectable minimale de l'ordre de 6 GeV). Et ils n'observent rien ! Nada. Nothing. Que dalle. Il n'y a pas d'interactions de WIMPs dans le xénon liquide du détecteur LUX!

Ils atteignent une sensibilité de détection hors norme, permettant d'explorer une zone jusqu'alors jamais atteinte (une section efficace qui descend jusque 10-45 cm² et une masse détectable minimale de l'ordre de 6 GeV). Et ils n'observent rien ! Nada. Nothing. Que dalle. Il n'y a pas d'interactions de WIMPs dans le xénon liquide du détecteur LUX!

Du moins, rien de plus que le maigre bruit de fond attendu, exactement la quantité de bruit de fond attendu, pas de signal...

Comme je le disais dans le post précédent sur LUX, le fait qu'ils ne détectent rien met un très sérieux coup à l'hypothèse WIMP et surtout l'hypothèse apparue ces trois dernières années d'une WIMP de l'ordre de 10 GeV pour expliquer la matière noire. Les indices de détection qui avaient été donnés par CoGENT et CDMS, ainsi que ceux de CRESST et de DAMA sont complètement exclus par ces tout nouveaux résultats que viennent de nous annoncer les physiciens de LUX.

Ce résultat est très important, il veut dire que le concept de particule supersymétrique interagissant très faiblement avec la matière n'est sans doute pas la bonne piste pour expliquer la masse manquante observée dans les galaxies et les amas de galaxies...

Le mystère de la matière noire reste donc entier, sachant que l'hypothèse WIMP est sans doute maintenant dans une impasse.

Référence (papier accompagnant la présentation) :

http://luxdarkmatter.org/papers/LUX_First_Results_2013.pdf

Ce résultat est très important, il veut dire que le concept de particule supersymétrique interagissant très faiblement avec la matière n'est sans doute pas la bonne piste pour expliquer la masse manquante observée dans les galaxies et les amas de galaxies...

Le mystère de la matière noire reste donc entier, sachant que l'hypothèse WIMP est sans doute maintenant dans une impasse.

Référence (papier accompagnant la présentation) :

http://luxdarkmatter.org/papers/LUX_First_Results_2013.pdf

Lire aussi : LUX, un Détecteur à la recherche de la Matière Noire